添加主存储

在ZStack Cloud主菜单,点击,进入主存储界面。点击添加主存储,弹出添加主存储界面。

添加主存储分为以下场景:

- 添加本地存储 (Local Storage)。

- 添加NFS主存储。

- 添加Shared Mount Point主存储。

- 添加Ceph主存储。

- 添加Shared Block主存储。

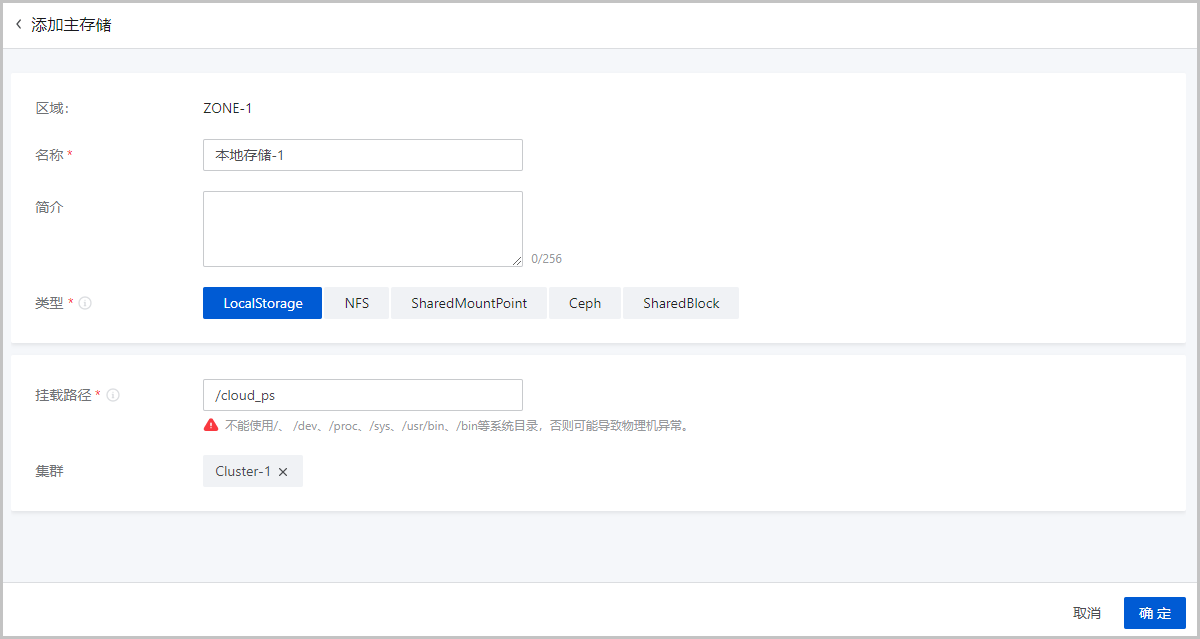

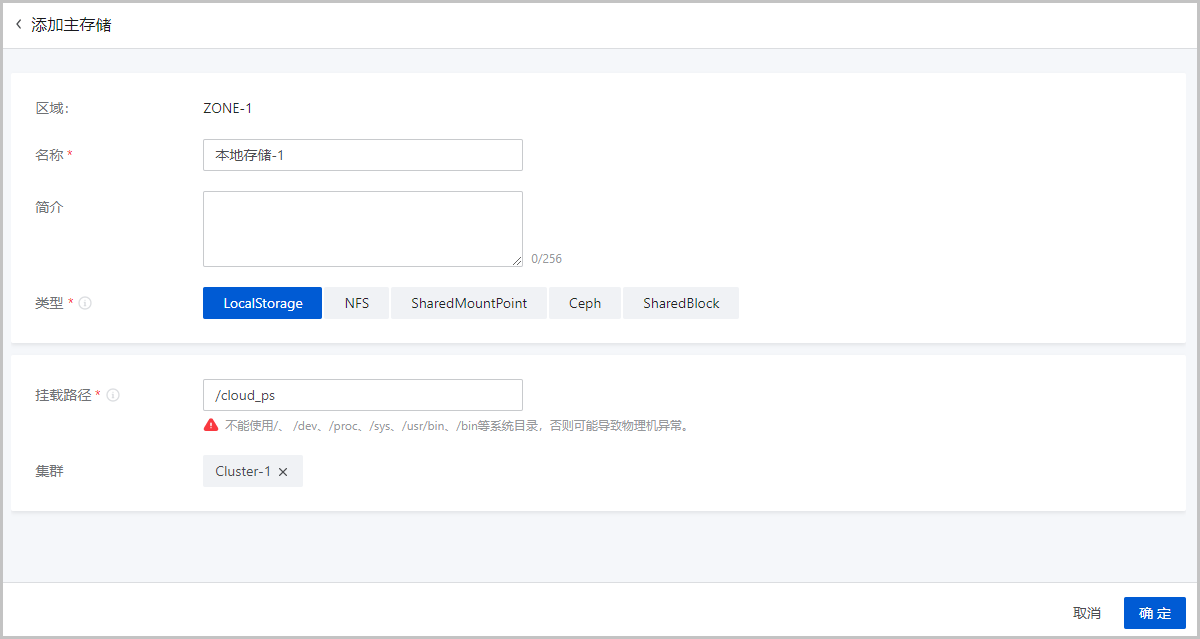

添加本地存储 (Local Storage)

可参考以下示例输入相应内容:

- 区域:显示当前区域

- 名称:设置主存储名称。命名规则:长度限制1~128字符,输入内容只能包含中文汉字、英文字母、数字、空格和以下 7

种英文字符

- _ . ( ) : +且不支持以空格开头或结尾 - 简介:可选项,可留空不填

- 类型:选择LocalStorageNote:

- 如果主存储类型采用本地存储(Local Storage),那么使用各物理机的本地硬盘目录作为主存储,匹配ImageStore或SFTP镜像服务器,容量由各物理机的目录容量累加。

- 如果加载多个本地存储(Local Storage),请确保每个本地存储必须部署在独占的逻辑卷或物理磁盘上。

- 挂载路径:输入本地存储的路径Note:

- 若输入的目录不存在,系统将自动创建该目录。

- 不能使用以下系统目录,使用系统目录可能会导致物理机异常。

- /

- /dev

- /proc

- /sys

- /usr/bin

- /bin

- 集群:选择本地存储需要加载的集群

如Figure 1所示:Figure 1. 添加本地存储 (LocalStorage)

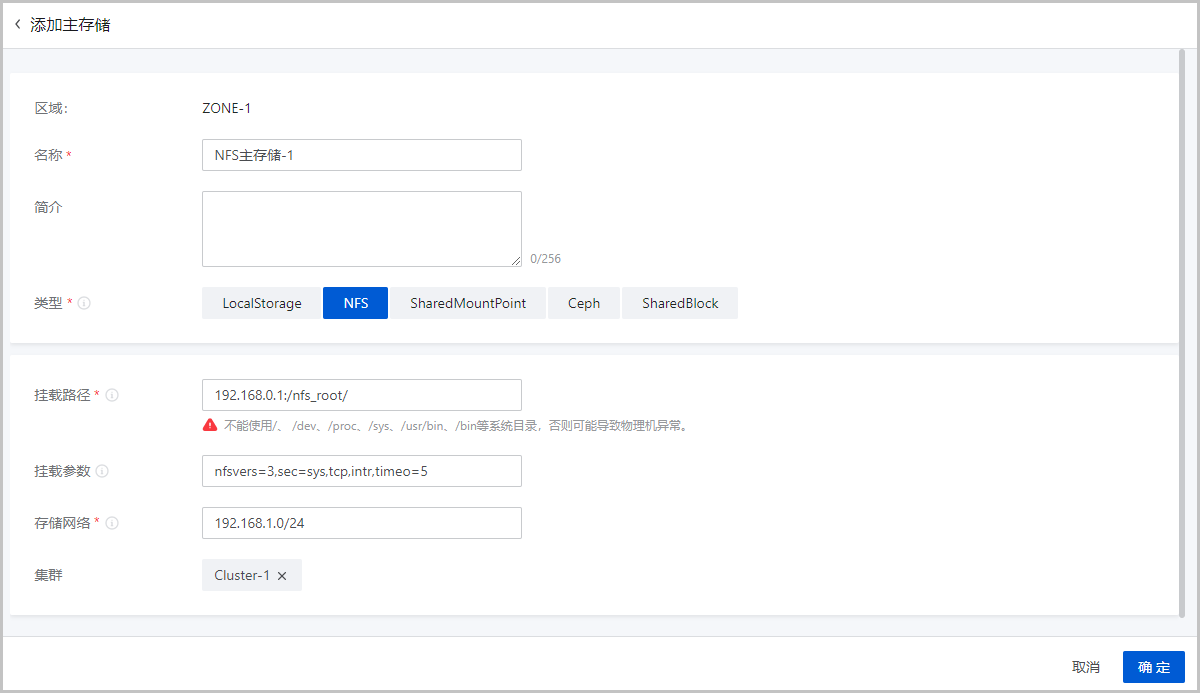

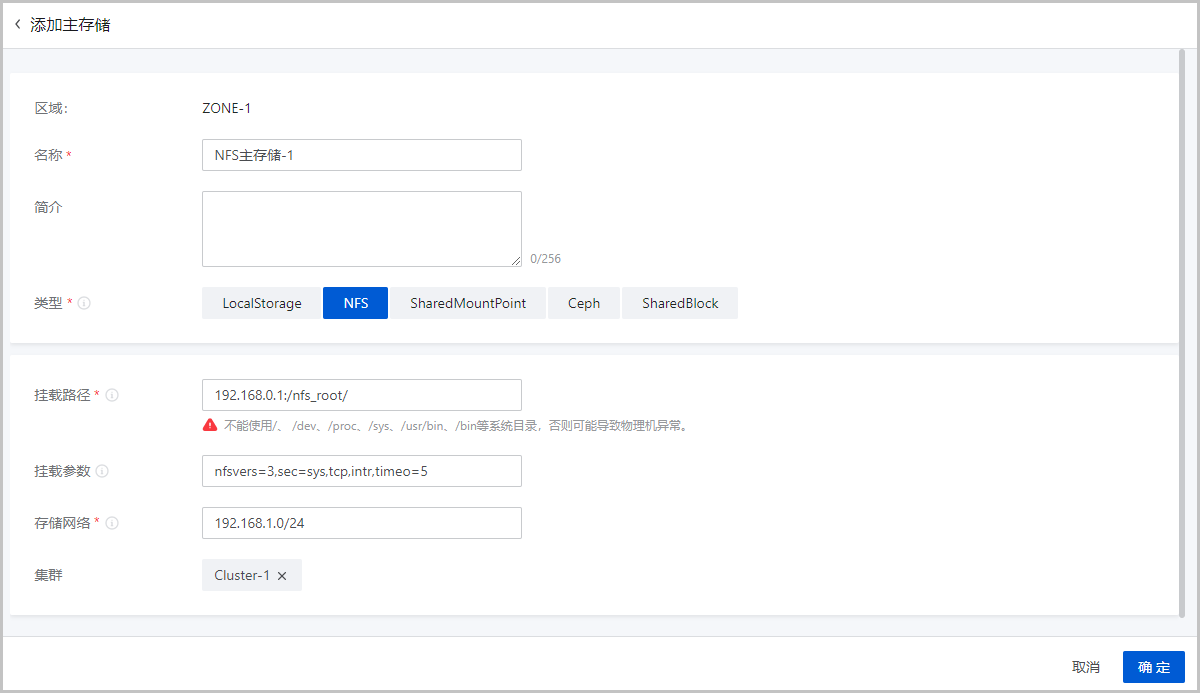

添加NFS主存储

可参考以下示例输入相应内容:

- 区域:显示当前区域

- 名称:设置主存储名称。命名规则:长度限制1~128字符,输入内容只能包含中文汉字、英文字母、数字、空格和以下 7

种英文字符

- _ . ( ) : +且不支持以空格开头或结尾 - 简介:可选项,可留空不填

- 类型:选择NFSNote: 如果主存储类型采用NFS,那么ZStack Cloud会在所有物理机上自动加载相同的NFS共享目录作为主存储。匹配ImageStore或SFTP镜像服务器,会在所有物理机上自动挂载此目录。

- 挂载路径:输入NFS Server的共享目录URL,支持输入IP或域名Note:

- 输入格式为:NFS_Server_IP:/NFS_Share_folder,例如:192.168.0.1:/nfs_root

- 请提前在NFS Server端设置相应目录的访问权限。

- 为保证在NFS Server端的安全控制,建议配置相应安全规则,进行访问控制。

- 用户可以提前在NFS Server端通过

showmount -e命令检查NFS Server已共享的目录。 - 不能使用以下系统目录,使用系统目录可能会导致物理机异常。

- /

- /dev

- /proc

- /sys

- /usr/bin

- /bin

- 挂载参数:可选项,需NFS Server端支持Note:

- 参数以逗号隔开。例如:输入nfsvers=3,sec=sys,tcp,intr,timeo=5,表示:NFS Server端的版本为3,采用标准的UNIX验证机制,采用TCP作为传输协议,允许通知中断一个NFS调用,设置超时时间为0.5秒(5/10)。

- NFS的mount参数可以参考mount的-o选项里的内容。

- 可根据常用的客户端mount命令参数进行设置,如果设置的参数与NFS Server端冲突,则以Server端为准。

- 存储网络:用于表示共享存储指定的存储网络,可与节点的管理网络共用Note:

- 如果存在单独的存储网络,需填写存储网络CIDR。

- 建议提前规划单独的存储网络,以避免潜在风险。如无单独存储网络,建议根据实际情况填写。

- 云平台将使用此存储网络来判断云主机的健康状态。

- 集群:选择NFS主存储需要加载的集群

如Figure 2所示:Figure 2. 添加NFS主存储

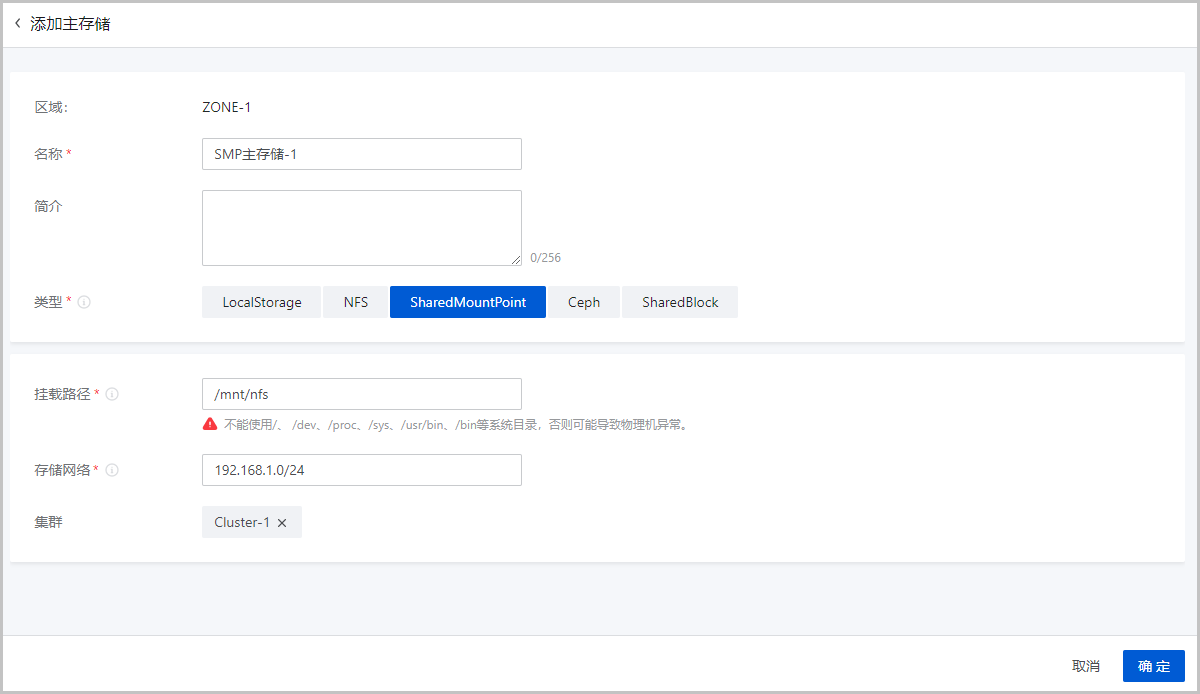

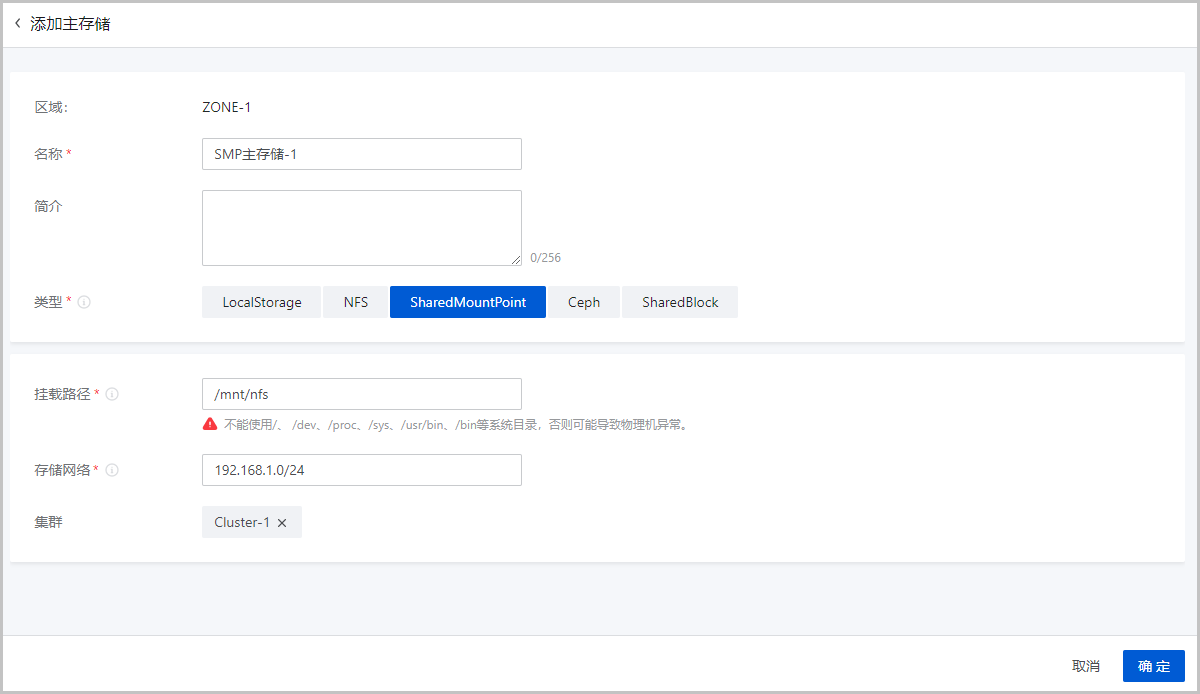

添加Shared Mount Point主存储

添加Shared Mount Point主存储,用户需提前配置好相应的分布式文件系统,并且根据不同存储系统的客户端配置,预先在每台物理机上把共享文件系统挂载在相同的文件路径。

以MooseFS为例配置主存储,方法如下:

- 用户需下载并安装MooseFS的客户端工具mfsmount,并且创建相应目录作为mount节点。

- 假定MooseFS的Master Server

IP地址为172.20.12.19,创建/mnt/mfs作为挂载点,使用

mfsmount命令挂载MooseFS系统。 - 用户也可根据需要使用

mfssetgoal命令设置相应的文件副本保存数量。

[root@localhost ~]#mkdir /mnt/mfs

[root@localhost ~]#mfsmount /mnt/mfs -H 172.20.12.19

[root@localhost ~]#mkdir /mnt/mfs/cloud

[root@localhost ~]#mfssetgoal -r 2 /mnt/mfs/cloud/

#以上命令将/mnt/mfs/cloud/目录的文件挂载到远端172.20.12.19,MooseFS存储服务器保留两份拷贝。可参考以下示例输入相应内容:

- 区域:显示当前区域

- 名称:设置主存储名称。命名规则:长度限制1~128字符,输入内容只能包含中文汉字、英文字母、数字、空格和以下 7

种英文字符

- _ . ( ) : +且不支持以空格开头或结尾 - 简介:可选项,可留空不填

- 类型:选择SharedMountPointNote:

- 如果主存储类型采用Shared Mount Point,那么ZStack Cloud可以支持MooseFS、GlusterFS、OCFS2、GFS2等常用的分布式文件系统提供的网络共享存储。

- Shared Mount Point主存储匹配ImageStore或SFTP镜像服务器。

- 挂载路径:输入物理机已挂载的共享存储目录URLNote:

- 不能使用以下系统目录,使用系统目录可能会导致物理机异常。

- /

- /dev

- /proc

- /sys

- /usr/bin

- /bin

- 不能使用以下系统目录,使用系统目录可能会导致物理机异常。

- 存储网络:用于表示共享存储指定的存储网络,可与节点的管理网络共用Note:

- 如果存在单独的存储网络,需填写存储网络CIDR。

- 建议提前规划单独的存储网络,以避免潜在风险。如无单独存储网络,建议根据实际情况填写。

- 云平台将使用此存储网络来判断云主机的健康状态。

- 集群:选择Shared Mount Point主存储需要加载的集群

如Figure 3所示:Figure 3. 添加Shared Mount Point主存储

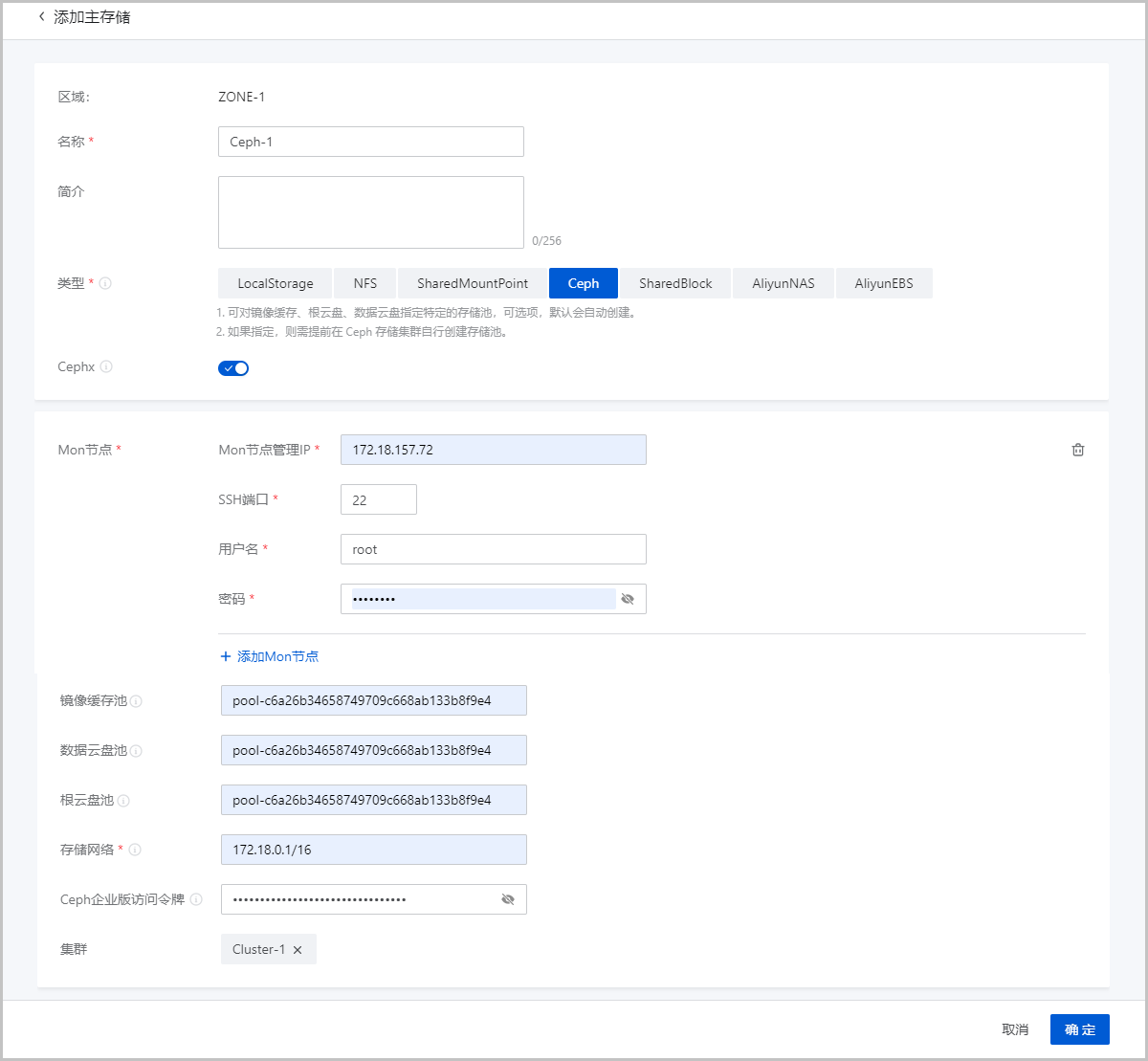

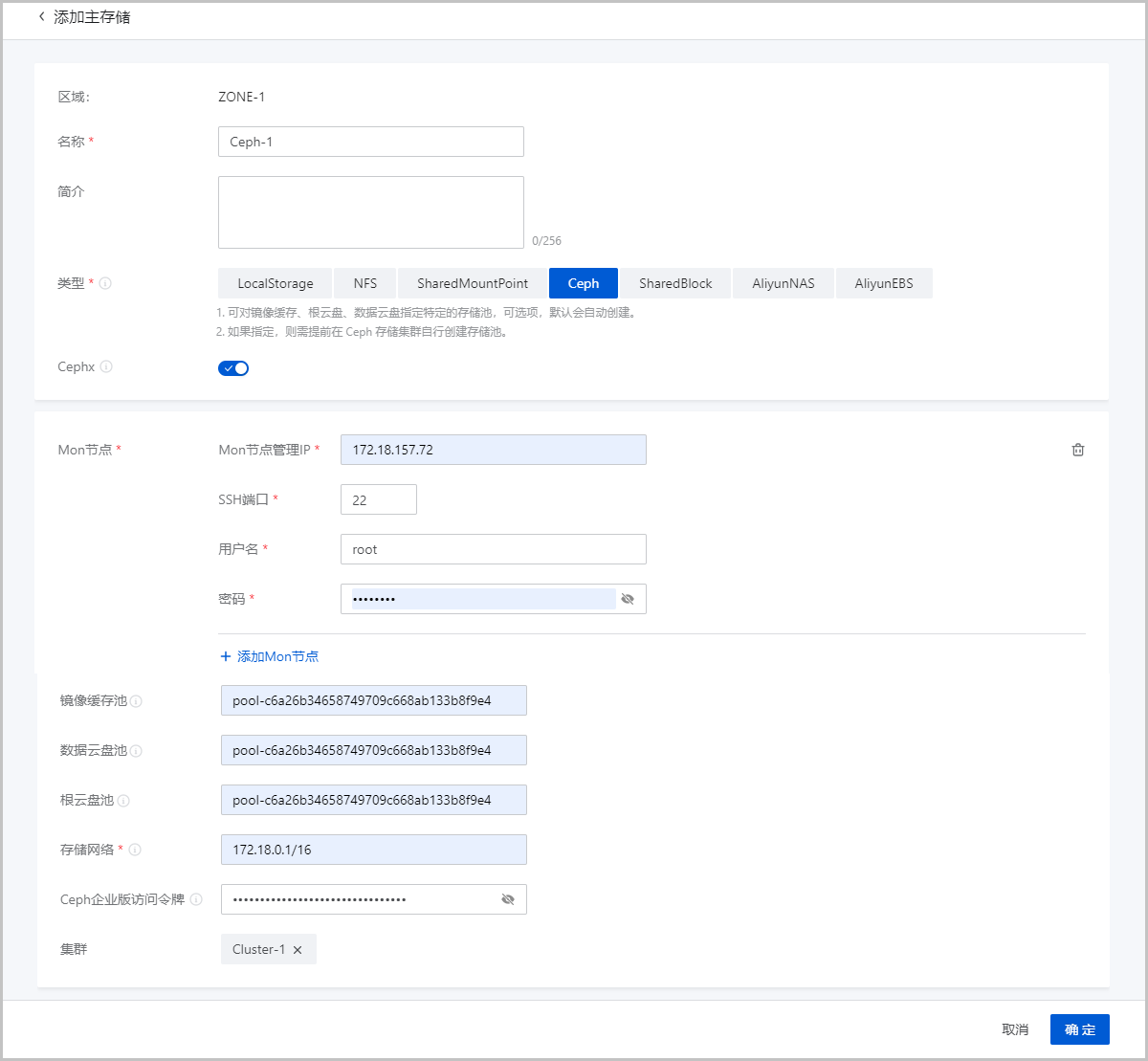

添加Ceph主存储

ZStack Cloud对Ceph的支持为块存储模式。如果主存储类型采用Ceph,则需先添加一个Ceph类型或ImageStore类型的镜像服务器,并且提前配置好Ceph分布式存储。

可参考以下示例输入相应内容:

- 区域:显示当前区域

- 名称:设置主存储名称。命名规则:长度限制1~128字符,输入内容只能包含中文汉字、英文字母、数字、空格和以下 7

种英文字符

- _ . ( ) : +且不支持以空格开头或结尾 - 简介:可选项,可留空不填

- 类型:选择CephNote: ZStack Cloud主存储支持对接以下版本Ceph:

- Ceph开源版:J版本、L版本和N版本。

- ZStack Ceph企业版:所有已发布的ZStack Ceph企业版。若更关注数据安全和IO性能,推荐使用ZStack Ceph企业版,详情请联系官方技术支持获取帮助。

- Cephx:可选项,可选择是否使用Ceph密钥认证功能Note:

- Cephx代表Ceph密钥认证,默认使用此功能。

- 如果存储节点和计算节点的网络较安全,可不使用Ceph密钥认证功能,以避免Ceph的认证失败。

- 需确保Ceph存储的密钥认证和此处行为保持一致。如果Ceph存储未关闭Cephx,此处使用Ceph密钥认证功能可能导致创建云主机失败。

- Mon节点:输入Ceph监控节点的IP地址、SSH端口、用户名和密码

- Mon节点管理IP:输入Ceph监控节点的IP地址

- SSH端口:输入Ceph监控节点的SSH端口,默认为22

- 用户名:输入Ceph监控节点的用户名

- 密码:输入Ceph监控节点的用户名对应的密码

可点击添加Mon节点继续添加Ceph监控节点。

- 镜像缓存池:可选项,可输入镜像缓存池名。Note:

- 支持对镜像缓存指定特定的存储池,若留空,系统默认自动创建镜像缓存池。

- 若指定存储池,需提前在Ceph存储集群自行创建存储池,并在云平台指定该存储池UUID。

- 数据云盘池:可选项,可输入数据云盘池UUIDNote:

- 支持对数据云盘指定特定的存储池,若留空,系统默认自动创建数据云盘池。

- 若指定存储池,需提前在Ceph存储集群自行创建存储池,并在云平台指定该存储池UUID。

- 根云盘池:可选项,可输入根云盘池UUIDNote:

- 支持对根云盘指定特定的存储池,若留空,系统默认自动创建根云盘池。

- 若指定存储池,需提前在Ceph存储集群自行创建存储池,并在云平台指定该存储池UUID。

- 存储网络:用于表示共享存储指定的存储网络,可与节点的管理网络共用Note:

- 如果存在单独的存储网络,需填写存储网络CIDR。

- 建议提前规划单独的存储网络,以避免潜在风险。如无单独存储网络,建议根据实际情况填写。

- 云平台将使用此存储网络来判断云主机的健康状态。

- Ceph企业版访问令牌:可选项,添加后将通过API token管理ZStack Ceph企业版存储Note:

- 建议弹性裸金属集群使用时填写。

- 需确保ZStack Ceph企业版存储许可证处于有效期之内。

- 集群:选择Ceph主存储需要加载的集群

如Figure 4所示:Figure 4. 添加Ceph主存储

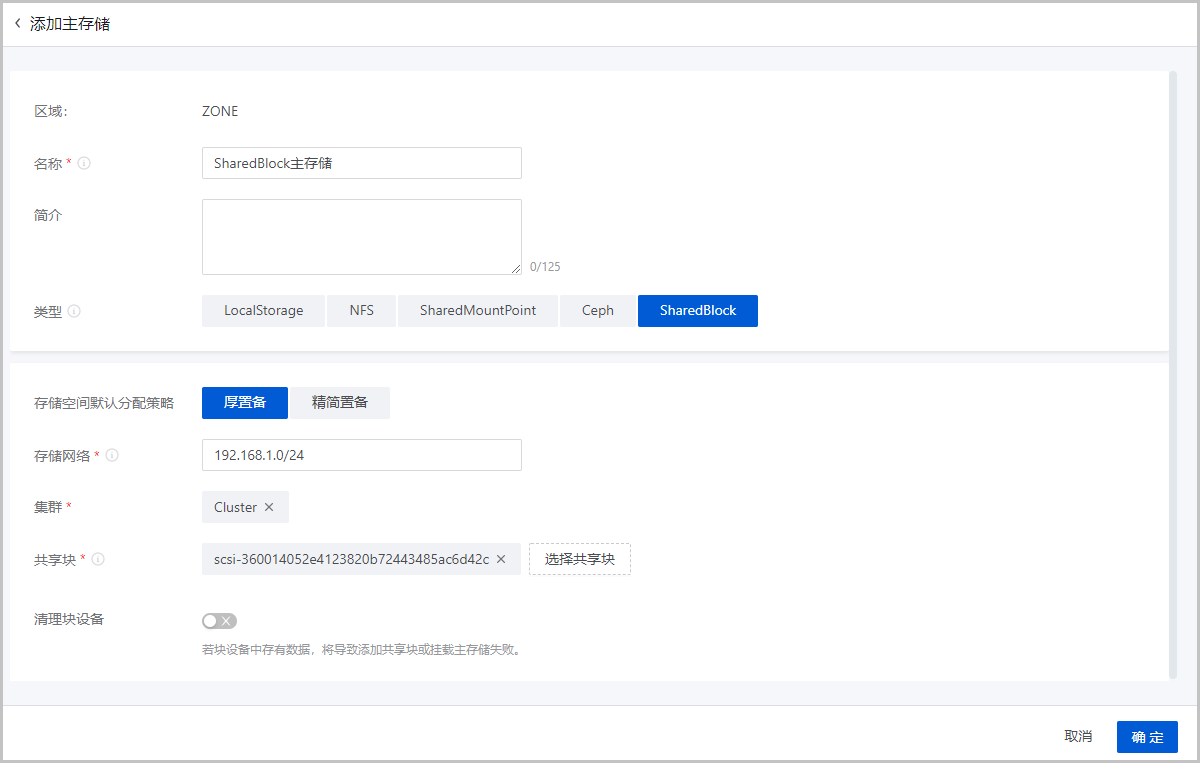

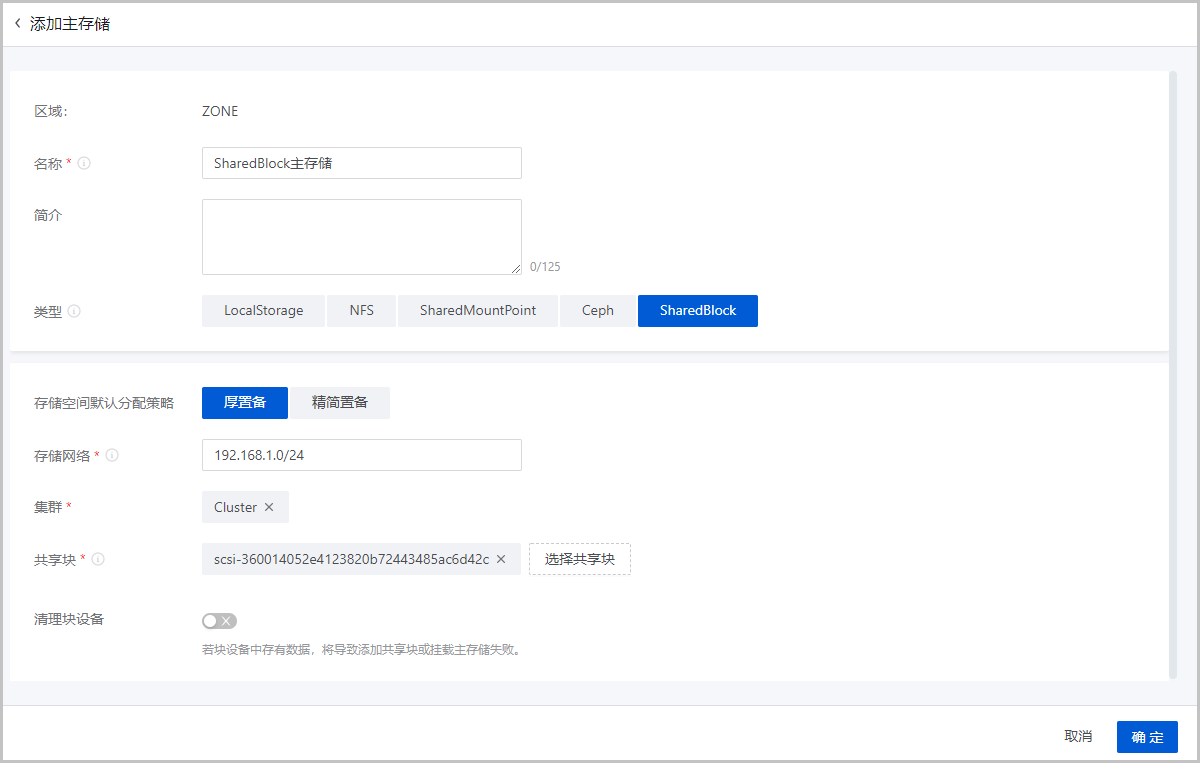

添加Shared Block主存储

可参考以下示例输入相应内容:

- 区域:显示当前区域

- 名称:设置主存储名称。命名规则:长度限制1~128字符,输入内容只能包含中文汉字、英文字母、数字、空格和以下 7

种英文字符

- _ . ( ) : +且不支持以空格开头或结尾 - 简介:可选项,可留空不填

- 类型:选择SharedBlockNote:

- Shared Block主存储采用了共享块存储方式,匹配ImageStore镜像服务器。

- 支持在线添加共享块设备(即LUN设备)。

- 目前Shared Block存储支持iSCSI、FC共享访问协议。

- 存储空间默认分配策略:选择存储空间默认分配策略,包括厚置备、精简置备

- 厚置备:预先分配需要的存储空间,提供充足的存储容量,保证存储性能

- 精简置备:按实际使用情况分配存储空间,实现更高的存储利用率

- 存储网络:用于表示共享存储指定的存储网络,可与节点的管理网络共用Note:

- 如果存在单独的存储网络,需填写存储网络CIDR。

- 建议提前规划单独的存储网络,以避免潜在风险。如无单独存储网络,建议根据实际情况填写。

- 云平台将使用此存储网络来判断云主机的健康状态。

- 集群:选择Shared Block主存储需要加载的集群

- 共享块:选择共享块设备,需输入磁盘唯一标识,支持添加多个共享块设备Note: 需确保计算节点已正常连接存储设备,且已添加到云平台。

- 清理块设备:可选项,可选择是否清理块设备。默认不清理

- 若选择清理块设备,将强制清理块设备中的数据,如文件系统、RAID或分区表中的标签等。

- 若块设备中存有数据,不清理块设备,将导致添加共享块或加载主存储失败。

- 添加的块设备中不能有分区,否则会添加失败。

如Figure 5所示:Figure 5. 添加Shared Block主存储